Copilotの安全な使い方を知ろう

生成AIを活用した業務効率化が進む中、Microsoft Copilotは多くの企業や個人ユーザーにとって頼れる存在になりつつあります。

しかし、便利さの裏にはセキュリティリスクが潜んでいることをご存じでしょうか?機密情報の取り扱いやアクセス管理を誤ると、情報漏えいや不正利用につながる可能性があります。特に「Copilotを導入したいけれど安全性が不安」「社内データを扱う際の注意点を知りたい」という方にとって、正しい知識は必須です。

本記事では、Copilotの基本からセキュリティ機能、他社AIとの比較、そして安全に利用するための具体的な対策まで徹底解説します。Copilotを安心して活用したい方や、セキュリティ面で悩んでいる方はぜひ参考にしてください。

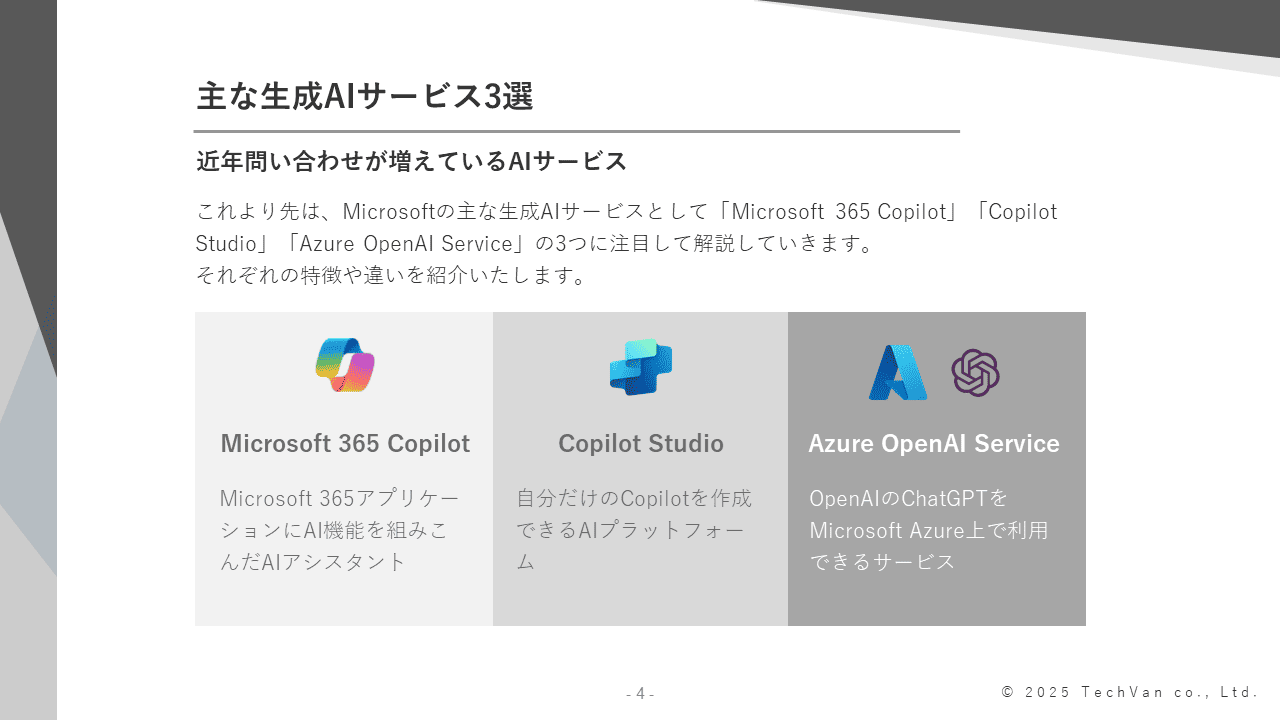

Microsoft Copilotとは?

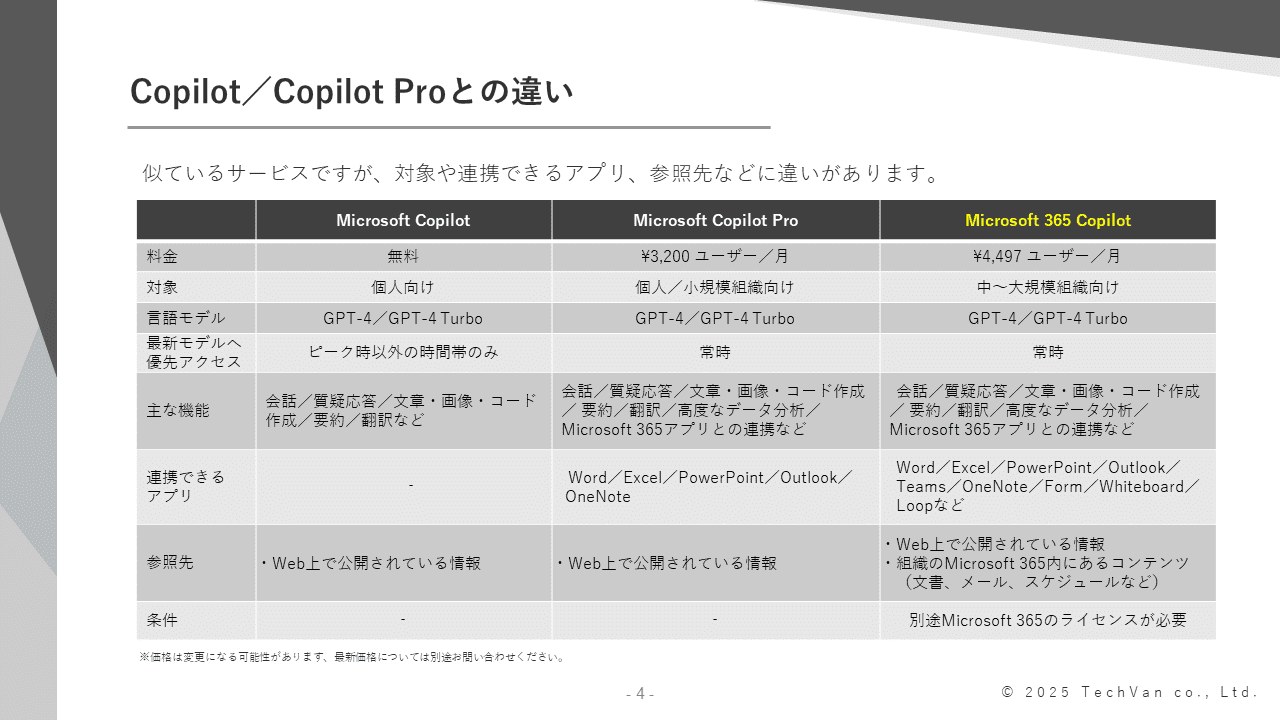

Microsoft Copilotは、業務効率化を強力にサポートするAIアシスタントツールです。

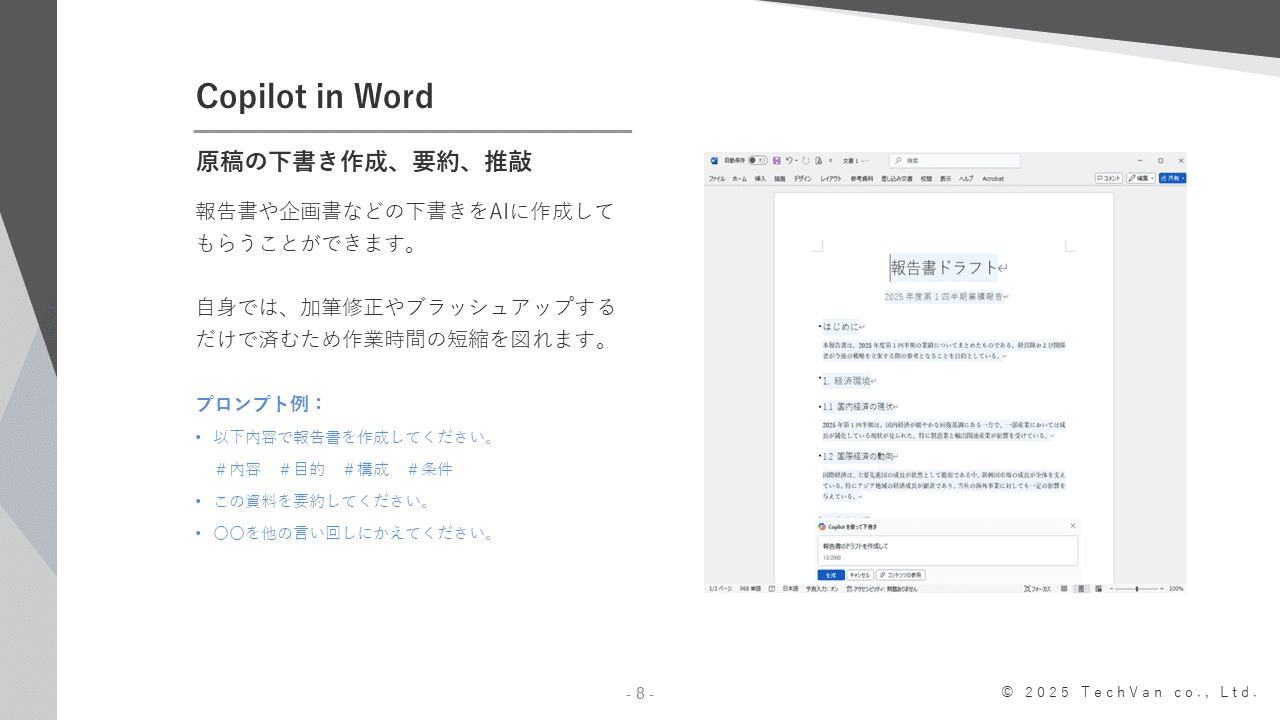

文章作成やデータ分析、会議の要約など、日常業務で時間がかかる作業を自動化し、よりクリエイティブな仕事に集中できる環境を提供します。

最大の特徴は、Microsoftのクラウド基盤と連携している点です。企業のセキュリティポリシーやアクセス権限を尊重しながら動作するため、ビジネス利用に適した安全性を確保しています。

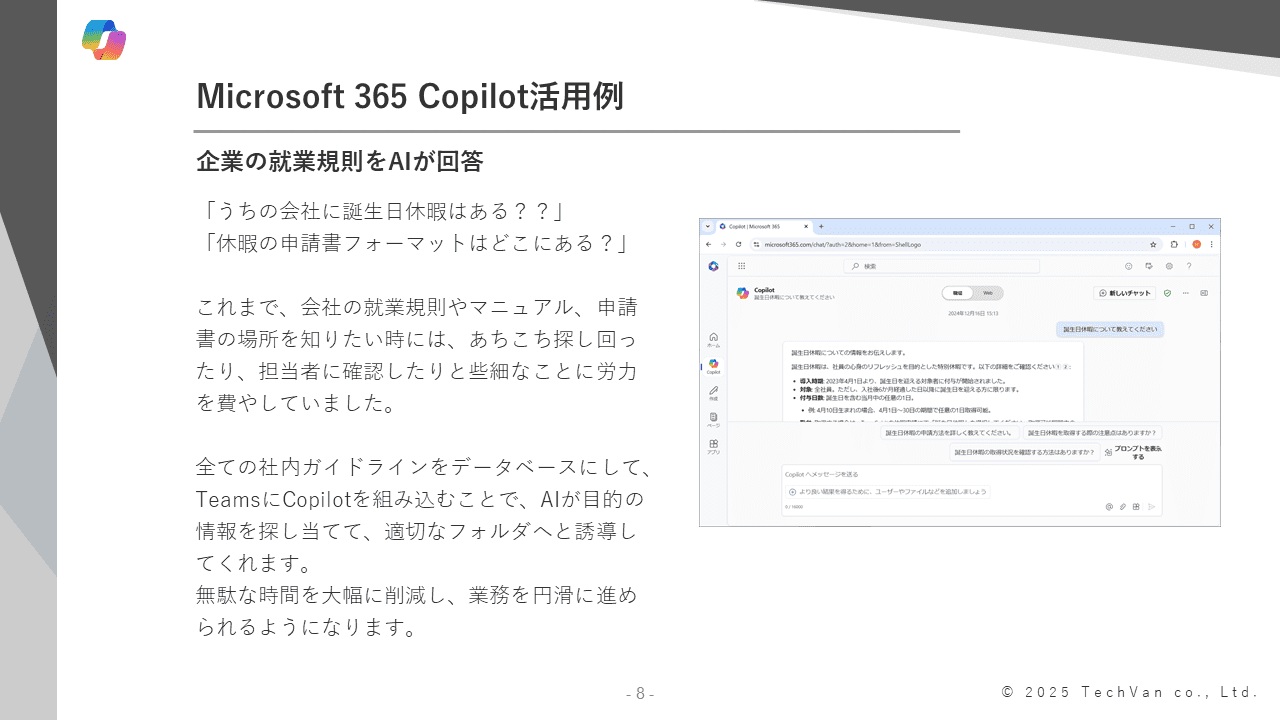

ChatGPTなど他サービスとの違いは、WordやExcel、TeamsなどのMicrosoft 365環境に深く統合されており、社内ドキュメントやメールを参照しながら、業務に即した提案を行える点です。

さらに、Microsoftのセキュリティ基準に基づいたデータ保護やコンプライアンス対応が組み込まれているため、企業利用において高い安全性を確保できます。「AIを業務に取り入れたいけれど、セキュリティ面が心配」という方にとって、安全性と利便性を両立したおすすめのツールといえます。

関連記事をご用意しております。併せてご覧ください。

▼CopilotとChatGPTの違いとは? 機能・料金・精度を徹底比較

生成AI利用におけるセキュリティリスク

生成AIを業務活用する際には、便利さの裏に潜むセキュリティリスクを理解することが重要です。

ここでは、以下の主に4つのセキュリティリスクリスクについて詳しく解説します。

- データの取り扱い

- 不正アクセス

- 生成AIによる誤情報

- 災害時のデータ損失

データの取り扱いに注意

生成AIは大量のデータを学習し、ユーザーの入力情報をもとに回答を生成します。

しかし、この仕組みには機密情報や個人情報が外部に漏れる危険性があります。例えば、社内文書や顧客情報を生成AIに入力した場合、その情報が学習データとして利用され、他者に共有されるリスクがあります。企業利用では、「どの情報を生成AIに扱わせるか」を明確にし、機密情報や個人情報を入力しないルールを徹底するようにしましょう。

また、利用する生成AIサービスのプライバシーポリシーやデータ保持方針を確認し、暗号化やアクセス制御が適切に行われているかのチェックが必要です。さらに、設定画面からオプトアウト申請し、入力した内容を学習させない設定にできるか確認するようにしましょう。

生成AIの利便性を最大限に活かすためには、データ管理の基本を徹底し、情報漏えいリスクを最小化することが不可欠です。

不正アクセスのリスクを理解

生成AIを利用する際、社内の人間でも本来アクセスできない情報に触れられる可能性があります。

なぜなら、生成AIは複数のデータソースを横断的に参照するため、権限設定が不十分だと、関係者以外が機密情報を閲覧できる状況が生まれるからです。

この問題を防ぐには、データの整理と権限管理の徹底が不可欠です。まず、生成AIに参照させるデータを最小限に絞り、機密情報は別の安全な領域に保管しましょう。さらに、アクセス権限を厳格に設定し、部署や役職ごとに閲覧可能な範囲を制限することが重要です。

不正アクセスは外部攻撃だけとは限りません。AI導入時には、技術的な防御と運用ルールの両面で対策を講じることが求められます。

生成AIによる誤情報の可能性

生成AIは便利ですが、出力する情報が常に正確とは限りません。

誤情報だと気付かずに企業が発信すると、社会的信用を失うだけでなく、法的リスクや顧客離れを招く恐れがあります。さらに、生成AIが生成した文章に著作権侵害の要素が含まれる場合、企業は責任を問われる可能性があります。

このリスクを回避するためには、ファクトチェックの徹底が不可欠です。生成AIの回答をそのまま公開するのではなく、専門担当者が内容を確認し、事実と異なる情報や引用元不明の記述を排除する仕組みを整えましょう。また、生成AIの利用範囲を「補助的な提案」に限定し、最終判断は必ず人間が行うことが重要です。

著作権侵害を防ぐためには、AIが生成したコンテンツの出典確認や、オリジナル性を担保する工夫も必要です。

関連記事をご用意しております。併せてご覧ください。

▼Copilotの商用利用を徹底解説:生成AIのリスクと安全な活用法

災害時のデータ損失のリスク

生成AIを利用する企業にとって、地震や火災などの災害時にデータが損失・消失するリスクは見過ごせません。

クラウドサービスを利用していても、サーバー障害や通信断が発生すれば、業務が停止し、重要な情報にアクセスできなくなる可能性があります。

このリスクを軽減するためには、定期的なバックアップが不可欠です。クラウド上のデータだけに依存せず、オンプレミスや外部ストレージにバックアップを保持することで、災害時も迅速に復旧できます。また、バックアップの頻度や保存場所を明確にし、復旧手順を事前に策定しておくことも重要です。

さらに、BCP(事業継続計画)の一環として、生成AIサービスが停止した場合の代替手段を準備しておくと良いでしょう。災害リスクを考慮したデータ保護体制を整えることで、企業の信頼性と業務継続性を確保できます。

Copilotのセキュリティ機能

Microsoft Copilotは、企業利用を前提とした強固なセキュリティ基盤の上で動作しており、安心して生成AIを活用できる環境を提供します。データの暗号化や厳密なアクセス制御に加え、生成AI特有のリスクに対応するための保護機能も備えている点が特徴です。

本章では、Copilotが持つセキュリティ機能の中でも特に重要な『データ保護』と『アクセス管理』に焦点を当て、その仕組みを詳しく解説していきます。

データ保護の仕組み

Copilotのデータ保護の中心にあるのが、Microsoft Entra IDによるアイデンティティ管理と、利用プランに応じて適用される商用データ保護(Commercial Data Protection)およびエンタープライズデータ保護(Enterprise Data Protection:EDP)です。

まず、一般利用向けのMicrosoft Copilot(無料版または一部の有料プラン)では、商用データ保護が適用されます。これは、Entra IDアカウントでサインインしたユーザーに提供される保護レベルで、暗号化やテナント分離、プライバシー保護など、企業利用に耐えうる基本的なセキュリティ対策が施されています。

一方、Microsoft 365 Copilotなど企業向けプランでは、より高度なエンタープライズデータ保護(EDP)が適用されます。EDPはMicrosoft 365の契約に基づき、プロンプトや応答を含むすべてのCopilotデータに対し、ExchangeのメールやSharePointのファイルなどと同等の企業向けセキュリティ・プライバシー基準を適用する強力な枠組みです。

例えば、データの暗号化、GDPR(General Data Protection Regulation:EU一般データ保護規則)・ISO/IEC 27018(個人情報の保護を目的とした国際規格)への準拠、テナントデータ分離、管理者による監査ログ・eDiscovery(電子情報開示)対応など、より厳格な保護が提供されます。

Copilotの企業向けプランであれば、より強固でビジネスに最適化されたセキュリティ環境を構築できるでしょう。

アクセス管理と制御

Microsoft Copilotは、Microsoft Entra IDと連携することで、ユーザーごとに厳密なアクセス権限を設定し、必要なデータだけを参照できるように制御可能です。

これは、社内の利用者であっても、業務上の必要性がない機密情報にはアクセスできないようにする『最小権限の原則』を実現するもので、不正アクセスや内部からの情報漏えいリスクを大幅に低減します。

Entra IDの権限モデルは、部署・役職・利用シナリオに応じた細かなアクセス制御を可能にし、Copilotが参照するデータもこの権限設定が適用されます。そのため、生成AIが誤って機密文書を引用したり、閲覧権限のないデータを出力したりすることを未然に防ぐことができます。また、秘密度ラベルやデータ分類機能といったMicrosoft 365のガバナンス設定とも連携し、企業独自のセキュリティポリシーをそのままCopilot利用時に適用できる点も強みです。

さらに、すべてのアクセスは監査ログとして記録され、管理者は利用状況を後から追跡・検証できます。これらの仕組みによって、Copilotは、企業の情報管理を支える重要なセキュリティ基盤として安全に運用できる環境を実現します。

Copilotと他社AI製品のセキュリティ機能比較

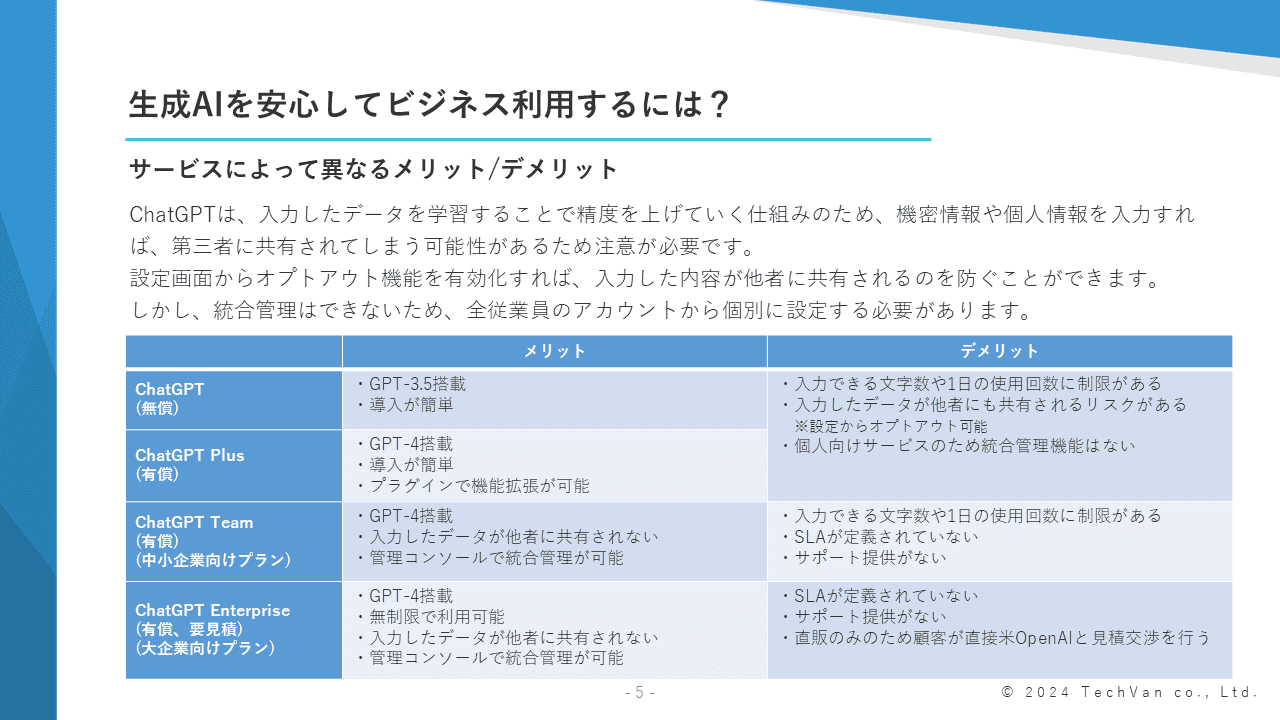

生成AIを安全に活用する上で、どのサービスがどの程度セキュリティ機能を備えているのかを正しく理解しておく必要があります。

ここでは、Microsoft Copilotのほか、ChatGPT、Google Geminiの2サービスについて、無料版と企業向け有料版に分けてセキュリティの特徴を比較します。

オープンエーアイ社が提供するChatGPTの無料版は、入力したデータがモデルの学習に利用される場合があり、データ保護は限定的です。しかし、ChatGPT EnterpriseまたはChatGPT Teamでは、データが学習に利用されず、SAML SSOやRBAC(Role-Based Access Control、ロールベースアクセス制御)が導入され、企業向けのガバナンスが強化されています。

グーグル社が提供するGemini(従来のBard)の無料版は一般的なプライバシーポリシーの範囲で動作し、ユーザーデータは改善のために利用される可能性があります。

しかし、Google Workspace with Gemini(Business/Enterpriseプラン)ではGoogle Workspaceのアクセス制御やDLP(データ損失防止)ポリシーが適用され、企業向けの保護が強化されます。

CopilotはMicrosoft 365環境と統合されているため、社内データへのアクセス権限をそのまま継承し、閲覧不可データを生成AIが参照・出力することがない点が大きな特徴です。

他社生成AI製品は、企業プランでセキュリティが強化されますが、Microsoft 365のガバナンスと完全連動する点はCopilot独自の強みといえます。

以下は、各製品をセキュリティ面で比較した表です。

|

データ保護 |

アクセス管理 |

データの学習利用 |

監査ログ・

コンプライアンス |

| Copilot(無料) |

商用データ保護(サインイン時)

|

Entra IDサインイン対応

|

なし

(企業アカウント時)

|

一部

|

| Microsoft 365 Copilot(有料) |

EDPによる高度な暗号化/テナント分離

|

Entra IDの権限を継承

|

なし

|

あり

|

| ChatGPT(無料) |

入力が学習に利用される可能性あり

|

特に制御なし

|

あり

(設定により変更可)

|

なし

|

| ChatGPT Enterprise(有料) |

学習に利用されない/SOC2準拠

|

SSO・RBAC対応

|

なし

|

あり

|

| Gemini(無料) |

データが改善に利用される場合あり

|

特に制御なし

|

あり

|

なし

|

| Google Workspace with Gemini(有料) |

WorkspaceのDLP・プライバシー保護適用

|

Workspace ACL・DLPと連動

|

企業向けは改善利用なし

|

あり(Google Workspace準拠)

|

※最新機能は、各公式サイトをご確認ください。

安全にCopilotを利用するための対策

Copilotを安全に活用するためには、ツール任せにせず、利用者側で適切な運用ルールを整えることが重要です。以下の対策を組み合わせることで、Copilotを安心して業務に取り入れられる環境が整うでしょう。

- 使用データの確認

入力するデータが機密情報や個人情報を含んでいないか確認することは、基本でありながら最も効果の高い対策です。

商用データ保護が適用されるとはいえ、誤って社外秘文書や顧客情報を入力すると、想定外の情報生成やデータ漏えいにつながる可能性もあります。そのため、社内で「生成AIに入力してよいデータ」「絶対に入力してはいけないデータ」を明確に定義し、従業員へ周知徹底することが欠かせません。

- アクセス権限の管理

CopilotはMicrosoft Entra IDを利用してユーザーごとの権限を管理できるため、必要な人だけが特定の情報にアクセスできる状況を簡単につくれます。部署や役職ごとに閲覧可能データを絞り込むことで、社内であっても不必要な情報参照を防ぎ、内部不正や誤操作による情報漏えいリスクを大幅に減らせます。

- 定期的なセキュリティレビュー

生成AIは便利な一方で、運用ルールが形骸化しやすいため、権限設定の見直しや利用ログの確認、AI出力内容の品質チェックなどを定期的に行うことで、潜在的なリスクを早期に発見できます。特に組織内でCopilotの利用範囲が広がるほど、「誰が、どのデータを、どのように利用しているのか」の可視化が重要になります。

セキュリティリスクを最小限に抑えよう

※本記事の内容は2025年12月時点のものです。Microsoftの仕様や利用環境は変更する場合があります。